کاهش ۹۶ درصدی هزینه آموزش مدل زبانی هوش مصنوعی با GPU های انویدیا

انویدیا تو رویداد کامپیوتکس ۲۰۲۳ تقریبا مشابه سالهایی که توی این رویداد حضور داشته، دست پر ظاهر شده. تو این مراسم، بین هزینه استفاده از سرورهای CPU و GPU برای آموزش مدلهای زبانی هوش مصنوعی یه مقایسه قابلتوجهی انجام شد. به تازگی اعلام کردن که با استفاده از پردازشگرهای گرافیکی این شرکت، مشتریها میتونن با هزینه کمتر و زودتر به اهدافشون برسن. تا انتهای این خبر با بنچفا همراه باشید.

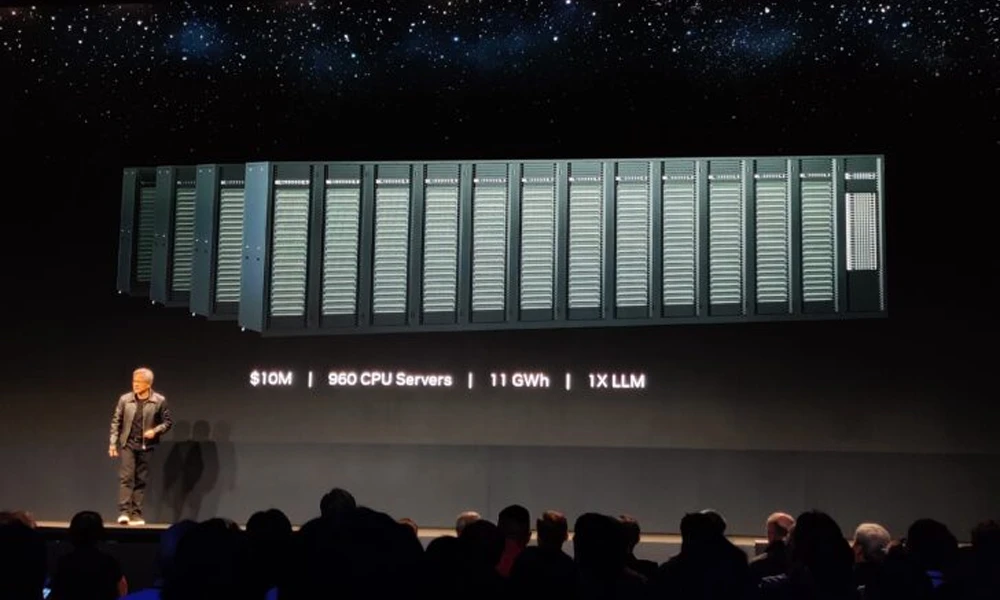

سرورهای مبتنی بر CPU برای آموزش LLM

در مراسم کامپیوتکس ۲۰۲۳، «جنسن هوانگ»، مدیرعامل انویدیا، مقایسهای بین هزینه استفاده از روشهای مختلف آموزش مدلهای هوش مصنوعی ارائه داد. اون گفت که برای آموزش فقط یک مدل زبانی بزرگ (LLM)، شرکتها الان باید از سروری که قیمتش ۱۰ میلیون دلاره و ۹۶۰ پردازنده مرکزی یا CPU داره استفاده کنن. علاوه بر اون، برای انجام این کار باید حدوداً ۱۱ گیگاواتساعت برق مصرف کنن.

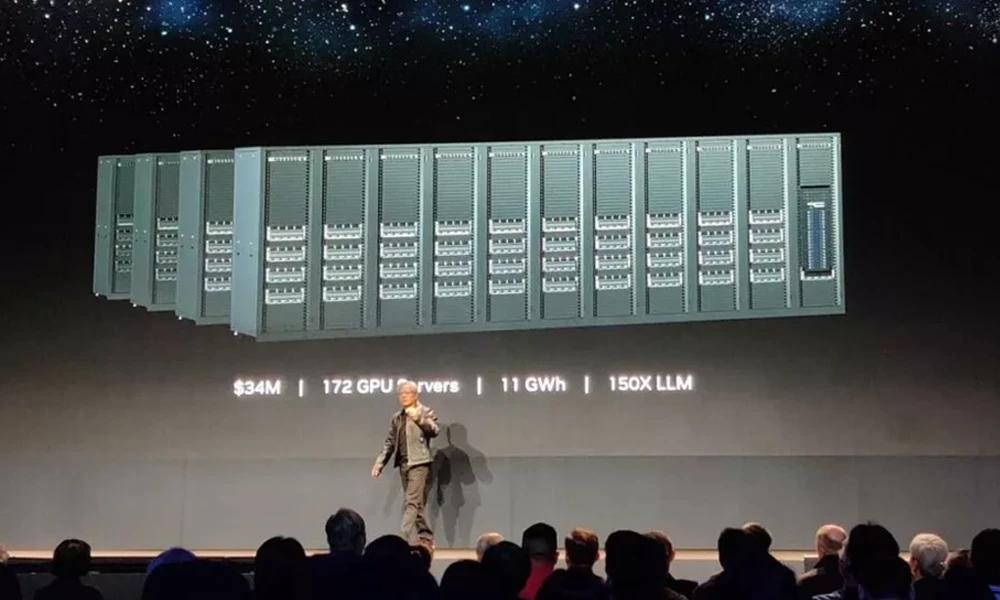

اما اگه یه شرکت سروری با پردازشگرهای گرافیکی انویدیا بسازه، برای آموزش یه مدل زبانی بزرگ فقط به ۰.۱۳ گیگاواتساعت برق و هزینهای حدوداً ۴۰۰ هزار دلار نیاز داره.

انویدیا تقریباً میگه شرکتها میتونن با استفاده از این پردازشگرهای گرافیکی با خرج کردن فقط ۴ درصد هزینه و ۱.۲ درصد از برق مصرفی سرورهای مبتنی بر CPU، یه مدل زبانی بزرگ برای سیستمهای هوش مصنوعی خودشون توسعه بدن. این حداقل هزینهها خیلی به شرکتها کمک میکنه. انویدیا همینجا تو رویداد، یه ابرکامپیوتر هم به نام DGX GH200 رو برای نسل بعدی مدلهای هوش مصنوعی معرفی کرد.

در واقع، اگه همین شرکتها سروری که قیمتش ۱۰ میلیون دلاره رو با GPUهای انویدیا بسازن، میتونن با فقط ۳.۲ گیگاواتساعت، ۴۴ مدل زبانی بزرگ رو آموزش بدن. این مقایسه رو بهش میگن «هزینه برابر»، چون هزینهها بهم نزدیک هستن. همچنین اگه توان برق مصرفی رو به ۱۱ گیگاواتساعت افزایش بدیم، با این GPUها میتونیم سرعت آموزش LLM هارو به 150X برسونیم. البته هزینه به ۳۴ میلیون دلار میرسه، ولی در نهایت ۱۵۰ مدل زبانی بزرگ در دسترس خواهد بود.

تفاوت سرورهای GPU با CPU

همونطور که اشاره کردیم، سرور های مبتی بر CPU نیازمند ۱۰ میلیون دلار هزینه و ۹۶۰ پردازنده بودن و با مصرف ۱۱ گیگاوات ساعت، فقط یک LLM رو آموزش بدن. اما با سرور های جدید مبتنی بر GPU که انویدیا معرفی کرده، به جای ۱۰ میلیون دلار، فقط با ۴۰۰ هزار دلار میشه سروری راه اندازی کرد که با مصرف برق ۰.۱۳ گیگاوات ساعت، همون یک مدل زبانی بزرگ رو برامون آموزش بده. این یعنی کاهش ۹۶ درصدی هزینه و کاهش ۹۸.۸ درصدی در مصرف انرژی. این کاهشها به شرکتهای بزرگ اجازه میده تا با بودجه یکسان، پروژه هاشون رو با سرعت خیلی بیشتری رشد بدن و این یعنی سرعت پیشرفت هوش مصنوعی در آینده بسیار سریعتر از الان میشه! این تازه اولشه :)))