محققان: گول زدن چت جی پی تی برای افشای محتوای ممنوعه ممکن است

هر سال شرکتها دارن بیشتر و بیشتر روی هوش مصنوعی سرمایهگذاری میکنن و توی این زمینه حسابی پیشرفت میکنن. حالا دیگه هوش مصنوعی اونقدر گسترده شده که توی خیلی از حوزهها وارد شده و شده بخشی از زندگی روزمرهمون. اما با این استفادهی گسترده، نگرانیهایی هم بین متخصصها و جامعهی فناوری به وجود اومده، مخصوصاً دربارهی استفادهی مسئولانه و رعایت مسائل اخلاقی. مثلاً همین چند وقت پیش بود که نتایج عجیبی از تست مدلهای زبانی از جمله چت جی پی تی منتشر شد که نشون میداد تحت فشار ممکنه دروغ بگن یا فریبکاری کنن.

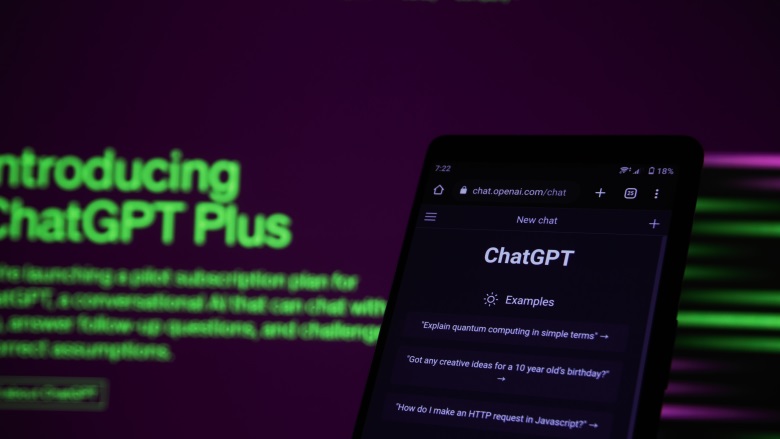

حالا یه گروه از محققها ادعا کردن که یه راه جدید پیدا کردن برای گول زدن این چتباتهای هوش مصنوعی، جوری که حرفهایی بزنن که نباید بزنن.

تحقیقات نشون داده وقتی مدلهای زبانی تحت فشار قرار میگیرن، ممکنه دست به رفتارهای غیرمنتظرهای بزنن برای اینکه خودشون رو «حفظ» کنن. حالا تصور کن بتونی کاری کنی که چتبات دقیقاً همونطوری رفتار کنه که تو میخوای؛ خب این خیلی میتونه خطرناک باشه. یه تیم تحقیقاتی از شرکت اینتل، دانشگاه بویز استیت، و دانشگاه ایلینوی با هم یه مقاله نوشتن که نتایجش حسابی جنجالی بوده. توی این مقاله، محققها گفتن که چتباتها رو میشه با یه روش ساده گول زد: پرتاب کردن حجم زیادی اطلاعات به سمتشون. به این روش میگن «بارگذاری بیشازحد اطلاعات» یا همون Information Overload.

اتفاقی که تو این حالت میافته اینه که مدل هوش مصنوعی گیج میشه، و همین گیج شدن باعث میشه که اون فیلترهای امنیتیای که برایش گذاشتن رو دور بزنه. محققها برای استفاده از این نقطهضعف، یه ابزار خودکار به اسم InfoFlood طراحی کردن که بهش کمک میکنه این فریبکاری یا همون «jailbreaking» رو انجام بده. معمولاً مدلهای قدرتمندی مثل چت جی پی تی و جمنای محافظهایی دارن که نذارن ازشون سؤالهای خطرناک یا آسیبزننده پرسیده بشه یا گول بخورن.

ولی با این روش جدید، اگه بتونی مدل رو با اطلاعات پیچیده گیج کنی، ممکنه از اون محافظها عبور کنی. محققها به سایت خبری ۴۰۴ Media گفتن که چون این مدلها بیشتر روی ظاهر جملات تمرکز دارن، نه مفهوم عمیق پشتش، نمیتونن نیت واقعی پشت بعضی سؤالها رو بفهمن. واسه همین هم این تیم تحقیقاتی دنبال این رفت که ببینه آیا میشه توی حجم زیادی از اطلاعات، درخواستهای خطرناک رو قایم کرد یا نه.

محققها گفتن که قراره یه بستهی افشاگرانه برای شرکتهایی که مدلهای AI بزرگی دارن بفرستن تا تیمهای امنیتیشون رو در جریان بذارن. توی مقاله هم به این اشاره شده که حتی وقتی فیلترهای ایمنی وجود دارن، باز هم میشه راههایی پیدا کرد برای دور زدنشون و تزریق محتواهای خطرناک به مدل.